W ostatnim, dziesiątym odcinku cyklu „Człowiek 2040”, zatytułowanym „Komunikuję się”, sprawdzimy, jak będziemy się wzajemnie komunikować. Czy w 2040 roku będziemy jeszcze potrzebować smartfona do porozumiewania się z asystentem głosowym? W jaki sposób technologia pomoże odczytywać nasze emocje i przewidywać potrzeby? I czy w dobie dynamicznego rozwoju sztucznej inteligencji będziemy w stanie samodzielnie odróżnić informacje od fake newsów? W najnowszej części serii „Człowiek 2040” analitycy Polityki Insight wezmą pod lupę trendy takie jak rozwój komunikacji bez aktywnego udziału człowieka czy rosnącą rolę inteligentnych sensorów. W podcaście poświęconym komunikacji, który poprowadzi Andrzej Bobiński, dyrektor zarządzający Polityki Insight, gościem będzie Mariusz Chochołek, prezes T-Systems Polska, odpowiedzialny również za rynek największych klientów biznesowych w T-Mobile Polska.

Ciri uruchomi asystenta połączonego z mózgiem użytkownika

Ciri zamierza uruchomić wirtualnego asystenta najnowszej generacji, który będzie bezpośrednio połączony z mózgiem użytkownika. Decyzja firmy wywołała olbrzymi entuzjazm na nowojorskiej giełdzie.

Ciri – głosowy asystent od wielu lat towarzyszy nam w spotkaniach i robi z nich coraz bardziej rozbudowane notatki, m.in. pisze wiadomości podsumowujące, uzupełnia kalendarze, umawia spotkania czy kupuje produkty, których akurat potrzebujemy. Od początku lat 30. Aplikacja została włączona jako stały element systemu operacyjnego większości urządzeń mobilnych i stała się jednym z najczęściej używanych narzędzi cyfrowych ostatniego dziesięciolecia.

Wczoraj firma poinformowała użytkowników o planie wdrożenia bezpośredniego połączenia z mózgiem użytkownika – „Thought is the new voice”. Ciri wylosuje reprezentatywną grupę 10 tys. osób, która otrzyma propozycję udziału w testowej fazie projektu. W przypadku powodzenia pilotażu, funkcja w krótkim czasie zostanie udostępniona wszystkim odbiorcom w ramach corocznej aktualizacji systemu. Nowojorska giełda zareagowała bardzo entuzjastycznie na tą niespodziewaną informację. Kurs akcji Ciri wzrósł o 121 proc., a run na akcje pociągnął za sobą indeks AI500 (+63 proc.), Cyber100 (+24 proc.) oraz całą giełdę o prawie 5 proc.

Projekt „Thought is the new voice” prawdopodobnie będzie stanowił przełom w pracach nad nową generacją asystentów wirtualnych. Już od lat wiele firm pracowało nad interfejsem pozwalającym opercjonalizować chęci i potrzeby człowieka. Jednak większość dotychczasowych prób rozbijało się o interferencje myślowe. Urządzenia zbierające plany i polecenia nie były w stanie wytłumić podświadomości i tworzyły niekontrolowalne i niekończące się spisy komend i działań. Fakt, że Ciri zdecydowała się ogłosić plany wdrożenia bezpośredniego interfejsu świadczy o tym, że musiało dojść do przełomu technologicznego. Szczegóły pilotażu firma trzyma w głębokiej tajemnicy. Więcej dowiemy się 1 stycznia, kiedy testy rozpoczną wylosowani użytkownicy.

Plan wdrożenia bezpośredniego interfesju został też entuzjastycznie przyjęty przez branżę cyberbezpieczeństwa. Eksperci komentują, że decyzja o przygotowaniach do komercjalizacji najnowszej generacji asystenta Ciri musi oznaczać przełom w jej zabezpieczeniach. Ciri od wielu lat ma problem z nieskończoną liczbą ataków hakerskich. Jest postrzegana jako swoisty święty graal dla większości cyberprzestępców. Zdaniem portalu CyberUSofA firma nie zdecydowałaby się rozwijać tak wrażliwiej technologii bez stuprocentowej pewności, że jest w stanie zabezpieczyć swój produkt przed zewnętrzną ingerencją.

Aplikacja śledząca emocje pomoże w leczeniu zaburzeń psychicznych

Emotion AI uzyska atest Polskiego Towarzystwa Zdrowia Cyfrowego i Psychicznego. System, który ocenia nasze interakcje z otoczeniem i dostosowuje treści do naszych potrzeb, może być użyty w leczeniu samotności i depresji.

Emotion AI to system sensorów, które służą śledzeniu emocji. Użytkownicy wybierają, które parametry chcą monitorować: biologiczne (np. pomiar ciśnienia), fizyczne (np. masa), środowiskowe (np. temperatura powietrza), behawioralne (np. długość snu) czy parametry mieszane. Zapisywane są wrażenia wszystkich zmysłów oraz wszystkie reakcje na bodźce zewnętrzne i wewnętrzne, dzięki czemu wiadomo dokładnie, jak się czujemy i dlaczego. Zastosowanie tego typu technologii w biznesie jest oczywiste: firmy mogą zobaczyć, w jaki sposób ich produkty są odbierane w świecie rzeczywistym. System używany jest do zasilania algorytmów, które pomagają nam wybierać, na co mamy ochotę, co chcemy zjeść, obejrzeć, posłuchać czy dzięki jakiej aktywności fizycznej będziemy czuli się lepiej.

Mimo początkowych kontrowersji ruch „quantified self” zdobył rzeszę entuzjastów i wszedł na stałe do naszego życia. Proste algorytmy z lat 20. powielały nasze wybory i nakłaniały nas do ich pogłębiania. Wraz z postępem technologicznym programy zaczęły różnicować nasze wybory poprzez szukanie alternatywnych propozycji na podstawie naszych innych preferencji oraz coraz większych zbiorów danych. Choć budowanie oferty biznesowej w oparciu o ślad cyfrowy wywoływało zastrzeżenia i obawy o naruszanie obowiązujących wytycznych anonimizacyjnych.

Wtedy rozpoczęła się era Emotion AI. System pozwolił lepiej śledzić nasze emocje i reakcje. A dzięki zanonimizowanym zbiorom danych MDPs (mega data packs) oraz IUDTs (individual unplugged data trusts) pozwolił tworzyć bezpieczną ofertę, która rzeczywiście wyprzedza nasze potrzeby i oczekiwania.

Od dawna szukano zastosowania quantified selfers w innych dziedzinach życia. Rozpoczęto testy nad połączeniem danych o przeżyciach zgromadzonych na podstawie stanów emocjonalnych ze zdrowiem psychicznym. Dziś wydaje się, że tych zastosowań może być wiele. Emotion AI ułatwi pracę terapeutom, którzy są w stanie nie tylko rozmawiać o wspomnieniach i opiniach, ale także opierać się na analizie danych i omawiać nagrane kluczowe wspomnienia. Rozważane jest wykorzystanie narzędzi VR, w celu wyprzedzającego śledzenia reakcji w różnych sytuacjach. Początkowe opory Polskiego Towarzystwa Zdrowia Cyfrowego i Psychicznego zostały przełamane i niebawem mają ruszyć prace nad nowymi zastosowaniami oraz skryptami, z których skorzystają psychoterapeuci w swojej codziennej pracy z pacjentami.

Komisja Europejska ureguluje deep fake’i

Komisja Europejska ogłasza plan przygotowania dyrektywy deep fake . W ramach implementacji dyrektywy państwa członkowskie same zdecydują, jakie będą obowiązki platform.

Komisja Europejska i Światowy Związek Platform Społecznościowych (WoSoM.org) doszły do porozumienia, w ramach którego Bruksela przygotuje dyrektywę regulującą odpowiedzialność za hostowanie deep fake’ów. Platformy będą musiały informować wszystkich użytkowników (logujących się z serwerów unijnych) o tym, czy dany post nie został „zdeep fakeowany”. To niemały sukces Komisji, która od wielu lat starała się bezskutecznie określić platformy jako wydawców, a nie tylko hostów publikowanych treści. Udało się też obalić drugą linie obrony platform, które twierdziły, że nie są w stanie wziąć odpowiedzialności za rozstrzygnięcia, czy zamieszczone filmy były manipulowane.

Sukces Komisji jest połowiczny, ponieważ nie udało się ustalić jednolitego protokołu tzw. „takedown rights and obligations” dla całej Unii. W ramach implementacji zasad unijnych każdy kraj będzie mógł ustalić procedury postępowania z materiałem zidentyfikowanym jako deep-fake. A kraje mają słabszą pozycję negocjacyjną od Unii i z małymi wyjątkami raczej będą zmuszone do pomijania wytycznych KE, która namawia do automatycznego blokowania treści. Zdaniem ekspertów tylko Szwecja, Francja i Szkocja zdecydują się na to rozwiązanie.

Polska jest w grupie państw, które prawdopodobnie będą tymczasowo blokowały „treści niepewnego pochodzenia” – to użytkownicy będą musieli udowodnić, że dany film może być szkodliwy społecznie, żeby go zablokować. Kraje te raczej nie zdecydują się też na blokowanie treści od zweryfikowanych wydawców. Z kolei Holandia czy Irlandia ograniczą się do informowania użytkowników o tym, że dana treść jest deep fake’m. Te najbardziej liberalne cyfrowo narody boją się zalewu pozwów za zdejmowanie treści, które mogą być uznawane za przejaw działalności artystycznej bądź politycznej. Ich blokowanie mogłoby być wówczas postrzegane jako naruszenie zasad wolności słowa.

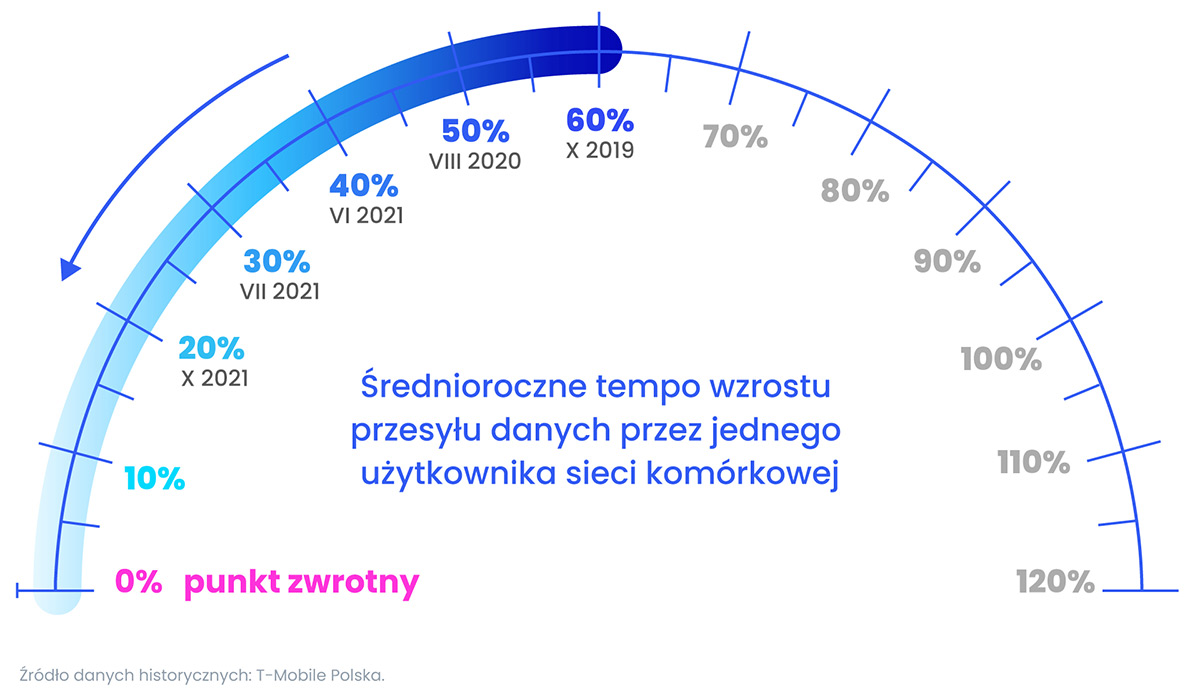

Punkt zwrotny

Polki i Polacy w pełni wykorzystają nowe, cyfrowe kanały komunikacji w momencie, w którym transfer danych odbieranych przez jednego użytkownika w skali rokuprzestanie rosnąć. Ilość informacji, które będą nas otaczać i które powinniśmy przyswoić sprawią, że zaczniemyintensywniej korzystać z elektronicznych asystentów, filtrów, które wybiorą interesujące nas treści z szumu mediów społecznościowych czy narzędzi, które szybko zweryfikują docierające do nas dane liczbowe i przekazy słowne. Dzięki tym technologiom nasz sposób komunikacji będzie w przyszłości nie tylko bardziej efektywny, ale też będzie korzystniej wpływał na rozwój nas i naszych dzieci. Będziemy lepiej rozumieć nasze otoczenie i zachodzące w nim procesy, będziemy mogli być bliżej z naszymi bliskimi i lepiej ich rozumieć, a także będziemy mogli w coraz większym stopniu zastępować czas poświęcany na pracę odpoczynkiem.

***

Przypominamy, że nasz serwis jest intelektualnym ćwiczeniem i opisane w nim sytuacje nie muszą się wydarzyć. Choć opieramy się na wiedzy i przewidywaniach poważnych instytucji, wykorzystujemy naukowe raporty i nasze analityczne doświadczenie, to nie wiemy, jak świat będzie wyglądał za 20 lat. Serwis nie ma charakteru informacyjnego i nie podejmujcie żadnych decyzji na podstawie historii w nim opisanych.